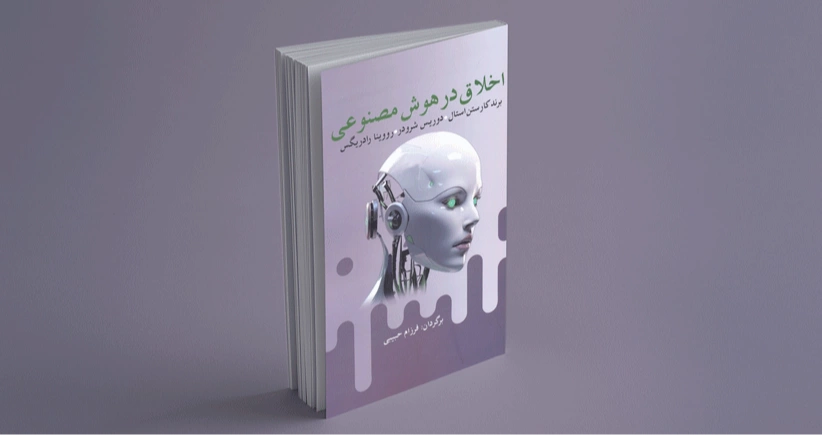

اخلاق در هوش مصنوعی/ چالشهای نوین هوش مصنوعی

کتاب «اخلاق در هوش مصنوعی» نوشتهی مشترک برند کارستن استال، دوریس شرودر و رووینا رادریگس به همت انتشارات آریابان به چاپ رسیده است. چالشهای اخلاقی ارائهشدهی هوش مصنوعی (AI) یکی از بزرگترین موضوعات قرن بیستویکم است. گفته میشود که مزایای بالقوهی هوش مصنوعی بسیار زیاد است ـ از پیشرفتهای عملیاتی مانند کاهش خطای انسانی (بهعنوان مثال در تشخیص پزشکی) تا استفاده از رباتها در موقعیتهای خطرناک (مانند ایمنسازی یک نیروگاه هستهای پس از حادثه). درعینحال، هوش مصنوعی بسیاری از نگرانیهای اخلاقی، مانند سوگیری الگوریتمی و شکاف دیجیتال تا نگرانیهای جدی سلامت و ایمنی، را مطرح میکند.

حوزهی اخلاق هوش مصنوعی به یک شرکت جهانی با طیف وسیعی از بازیگران تبدیل شده است. بااینحال اخلاق هوش مصنوعی چیز جدیدی نیست. مفهوم هوش مصنوعی تقریباً هفتاد سال قدمت دارد و نگرانیهای اخلاقی دربارهی هوش مصنوعی از اوایل قرن بیستم مطرح شده است. این بحث اکنون به لطف نگرانیهای گستردهتر در مورد استفاده و تأثیر الگوریتمهای بهتر، در دسترس بودن روبهرشد منابع محاسباتی و افزایش مقادیر دادهای که میتواند به منظور تجزیه و تحلیل استفاده شود، سرعت فوقالعادهای یافته است.

این پیشرفتهای فنی انواع خاص هوش مصنوعی را، بهویژه یادگیری ماشینی، که یادگیری عمیق یکی از انواع آن است، مورد توجه و پسند قرار داده. موفقیت هر رویکرد منجر به گسترش مجموعهای از کاربردها شد که اغلب پیامدهایی در پی داشتند و از نظر اخلاقی مشکلساز تلقی میشدند که میتوان به نمونههایی مانند تبعیض ناعادلانه یا غیرقانونی، طرد و مداخلهی سیاسی اشاره میکرد.

با استفادههای جدید از هوش مصنوعی، اخلاق هوش مصنوعی فراتر از دانشگاهها شکوفا شده است. برای نمونه دعوت رُم برای اخلاقیات هوش مصنوعی، که در فوریهی 2020 راهاندازی شد، واتیکان را با سازمان غذا و کشاورزی سازمان ملل متحده، مایکروسافت، آی بی ام و وزارت نوآوری ایتالیا مرتبط میکند. مثال دیگر این است که یونسکو در سال 2021، 24 کارشناس را در سراسر جهان منصوب و یک مشاورهی آنلاین جهانی در مورد اخلاق هوش مصنوعی راهاندازی کرد تا گفتوگو و تبادلنظر با همهی کشورهای عضو این سازمان آسانتر صورت پذیرد.

علاقهی رسانهها به این موضوع نیز قابل توجه است، گرچه برخی دانشگاهیان، برخورد و توجه رسانهها را «کمعمق» و «سطحی» میدانند.

یکی از مشکلات بزرگی که اخلاق هوش مصنوعی و اخلاقمداران ممکن است با آن مواجه شوند، مبهم بودن آن چیزی است که واقعاً در هوش مصنوعی رُخ میدهد و این امر با توجه به این نکته است که درک خوب بودن یک فعالیت، بهخودیخود در تعیین مسائل اخلاقی آن بسیار سودمند به شمار میآید.

انتظار میرود که اخلاقشناسان هوش مصنوعی با این تکنولوژی آشنا باشند، اما واقعیت این است که کمتر کسی واقعاً میداند که عملکرد الگوریتم بسیار پیشرفته چیست که شامل طراحان هوش مصنوعی نیز میشود.

علیرغم این عدم شفافیت هوش مصنوعی در اشکال کنونی آن، نکتهی مهم این است که چهجور و کدامیک از مسائل اخلاقی میتواند بهدلیل استفاده و توسعهی این تکنولوژی به وجود آید که این موضوعی قابل بحث و بررسی است. رویکردی که در این کتاب برای اخلاق هوش مصنوعی برگزیده شده بر پایه و با استفاده از بررسیها و پژوهشهای موردی است که بهعنوان «تجارت واقعی اخلاقیات هوش مصنوعی» ارائه و برای بحث، آموزش و تحلیل در نظر گرفته میشود.

قسمتی از کتاب اخلاق در هوش مصنوعی:

شرکتهای بزرگ اینترنتی مانند گوگل و آمازون از دادههایی که دربارهی مشتریان بالقوه جمعآوری میکنند، برای تبلیغ کالاها و خدماتی استفاده میکنند که الگوریتمهایشان نشان میدهد جستوجوگران به آنها نیاز دارند یا در پیشان هستند.

این رویکرد بهراحتی میتواند با مفهوم «لحظههای آسیبپذیری عمده» ترکیب شود، جایی که تجزیه و تحلیل دادهها بلادرنگ برای شناسایی چنین لحظاتی با جزئیات بسیار بیشتر از مطالعهی اولیه استفاده میشود.

دستکاری و نفوذ توصیفشده در این پژوهش موردی دوم در حال حاضر آنقدر گسترده است که امکان دارد دیگر قابلتوجه نباشد. اکثر کاربران اینترنت عادت دارند در تبلیغات هدف قرار بگیرند. زاویهی موردی که در اینجا جالب است، استفاده از «لحظهی آسیبپذیر اولیه» است که هنوز مفهومی نیست که بهطور گسترده در بازاریابی برنامههای هوش مصنوعی به آن اشاره شود.

فقدان کلمهای برای این مفهوم بدان معنا نیست که از یک رویکرد اساسی استفاده نشده است. شرکتی که تحقیق اولیه را انجام داد، این رویکرد را بهصورت مثبت و حمایتی بیان کرد. نتیجهی چنین استراتژی بازاریابی ممکن است درواقع برای مخاطب هدف مثبت باشد.

اگر فردی بهدلیل خستگی، لحظهای آسیبپذیر داشته باشد، پیشنهادات بهداشتی و سلامتی مربوطه ممکن است به مبارزهی با آن حالت کمک کند.

این ما را به سؤالی هدایت میکند: دستکاری و نفوذ در چه شرایطی رُخ میدهد و چگونه میتوان آن را از منظر اخلاقی ارزیابی کرد؟

تحلیل اخلاقی مفهوم دستکاری باید با تصدیق این نکته آغاز شود که این اصطلاح دارای مفاهیم اخلاقی است. دیکشنری آنلاین کمبریج تحلیل زیر را ارائه میدهد: «کنترل کسی یا چیزی به نفع خود و اغلب ناعادلانه یا ناصادقانه.»

همچنین دیکشنری کمبریج اضافه میکند که این رفتار به شیوهای ناپسند ارائه میشود. بنابراین چنین تعریفی چند نکته را ارائه میدهد که چرا دستکاری و نفوذ از نظر اخلاقی مشکلساز است.

عمل کنترل دیگران ممکن است نگرانکننده تلقی شود، بهویژه اینکه به نفع شخصی انجام میشود که اگر ناعادلانه یا ناصادقانه انجام گردد، ایجاد حس نگرانی در مورد آن تشدید میشود.

در اصطلاحات فلسفی سنتی، این حکم قاطع کانت است که چنین دستکاری و نفوذی را بهدلیل اخلاقی منع میکند؛ زیرا یک شخص صرفاً بهعنوان وسیلهای برای دستیابی به اهداف شخصی دیگر مورد استفاده قرار میگیرد.

یکی از جنبههای بحثی که به مطالعهی موردی اول مربوط میشود، این است که دستکاری رأیدهندگان از طریق هوش مصنوعی میتواند به دموکراسی آسیب بزند.

دستکاری رأیدهندگان با استفاده از هوش مصنوعی میتواند تحت نفوذ رأیدهندگان قرار گیرد. بااینحال مشخص نیست تحت چه شرایطی چنین نفوذی بر رأیدهندگان نامشروع خواهد بود.

بههرحال کمپینهای انتخاباتی صراحتاً هدفشان تأثیرگذاری بر رأیدهندگان و انجام این کار، کار روزمرهی سیاستمداران است.

به نظر میرسد این موضوع نهچندان تحت تأثیر رأیدهندگان رُخ دهد، بلکه مسأله این است که بدون اطلاع آنها و شاید بهگونهای اتفاق میافتد که توانایی آنها را برای انعکاس انتقادی پیامهای انتخاباتی نادیده میگیرد.

یک نگرانی اضافی، این واقعیت است که هوش مصنوعی بیشتر توسط شرکتهای بزرگ نگهداری و از آن استفاده میشود و اینکه آنها درحالحاضر تأثیر زیادی بر تصمیمگیریهای سیاست دارند که میتواند از طریق توانایی آنها برای تأثیرگذاری بر رأیدهندگان بیشتر شود.